在整个系列文章中,我们了解了Nutanix AOS解决方案相对于vSAN / VxRAIL的许多架构优势。

在这篇文章中,我们将展示一个示例,说明网络流量如何影响性能,在现实世界证明了我之前已经解释过的许多概念。在此示例中,我们将研究繁重的写入工作负载,例如大数据注入操作。

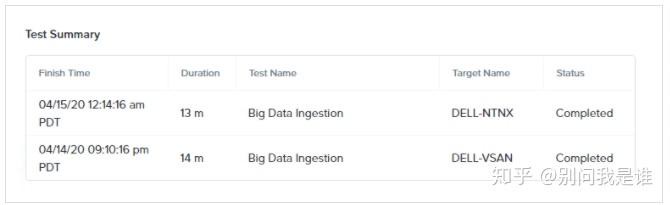

基准测试:

在两个完全相同的4节点集群,且完全空闲的情况下,我们使用X-ray测试大数据注入的场景,并且两个平台在相似的时间内完成了数据提取。

Nutanix AOS为13分钟,VMware vSAN为14分钟。

我们在下面显示的方案中,两种解决方案的网络利用率约为2GBps,而vSAN在测试一半左右的时候下降至1.5GBps。

接下来,我们在每台主机上运行iPerf,以模拟现实环境中的环境,该环境不仅服务于存储流量,而且还服务于VM之间和客户端-服务器之间的流量。

使用iPerf进行测试以生成网络流量:

下图显示了整个测试期间的网络带宽,其中包括iPerf(〜6GBps)和X-Ray中大数据注入(〜2GBps,根据之前的图表)场景所产生的流量,这两种平台都是相同的。

毫不奇怪,我们看到了一些影响,因为此测试是100%写入,并且两个平台都必须使用网络进行写入副本。

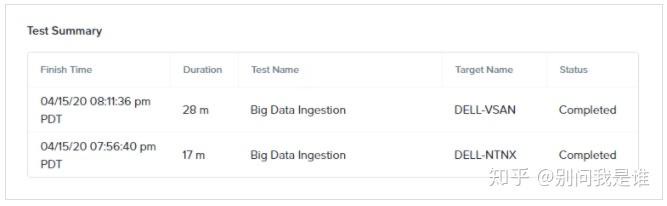

使用iPerf网络流量进行大数据提取测试的持续时间

对Nutanix的影响是该场景花费了额外的4分钟(增加了31%),而vSAN花费了额外的14分钟(增加了100%)。

为什么差异如此之大?

两个集群的网络流量几乎相同,并且都使用两个副本(RF2用于Nutanix,FTT1用于vSAN)。

本系列前面介绍的写入I / O路径比较说明了Nutanix根据集群容量利用率和性能在整个集群中动态分布副本。vSAN使用基于静态对象存储的分布式系统,这意味着它无法容忍和缓解单节点依赖或网络性能方面的约束,因此灵活性不同。

这是一个公平的比较吗?

这个测试是vSAN的最佳场景,因为X-Ray部署了VM并在创建它们的主机上运行它们。这意味着他们可以在本地享受最大的数据(尽管运气不错)。如果在此测试过程中将VM移至一台未托管VM对象的主机,则100%的写入(两个副本)将通过网络进行,而不是仅是一次。

这将是一个更现实的场景,因为VM可以/在HCI环境的整个集群中都可以移动,因此,如果我想展示产品之间的更大差异,我只需在测试之前或测试过程中vMotion VM。

总结:

当网络(实际上是HCI环境中的存储结构中的网络)被相当地利用(在这种情况下为8GBps的25GB NIC)时,这种情况会更接近现实环境,vSAN的性能可能会发生很大变化,而对于Nutanix归功于真正的分布式存储结构和智能(写入)副本放置,其影响要合理得多。

在比较平台时,使用iPerf之类的工具生成至少一些网络流量非常重要,因为与运行4k随机读取“峰值性能”基准的空闲集群相比,这有助于模拟更多实际场景。